死链是指失效或错误的链接,导致用户点击后无法打开页面,处理网站中的死链对于推广和搜索引擎优化至关重要,通过分析服务器日志可识别出404错误页面的死链,并采取多种方法进行处理,如提交死链列表给搜索引擎、设置错误导向至其他可用页面等,更新robots.txt文件以禁止爬行这些目录或页面也是有效手段之一,为避免恶意劫持和提高排名,建议安装SSL证书来保护数据传输安全及验证服务器身份;此外还需定期检查后台源码及时删除无效栏目与内容以确保网站的健康发展,必应搜索被k时需关注其内容和技术的质量问题并进行相应排查修复工作。

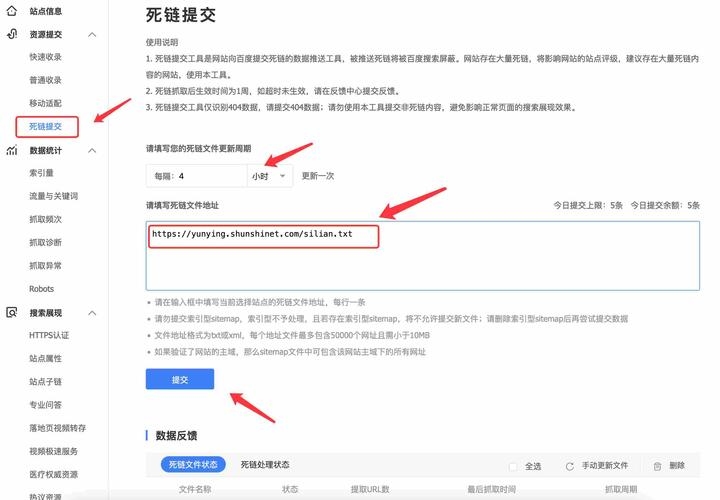

死链提交了,出现这也问题,说有活链接,我查过,都是死链的,这是怎么回...

所谓死链就是失效的链接、错误链接,用户在点击链接时打不开网页服务器直接跳转到404页面。网站出现死链对于网站的推广是非常不利的,因为搜索引擎是通过链接搜索到我们的网站,也是通过内链在我们的网站中爬行搜索的,如果出现死链就会让搜索引擎迷路,搜索引擎对于搜索引擎的好感就会下降,甚至会认为我们的网站是垃圾站点。

通过分析网站的服务器日志,可以识别出哪些页面返回了404错误,这些页面即为死链。网站优化中出现死链的处理方法 处理已售或删除文章产生的死链:对于因删除已售或不再需要的文章而产生的死链,建议向百度提交死链列表,请求其从搜索结果中删除这些链接。

设置错误页面导向:将死链页面导向至404页面,并通过404页面将用户引导至网站上其他可以打开的页面。这样做不仅可以告知搜索引擎该页面是不正常的,还能有效降低网站用户流失率。 更新robots.txt协议文件 编辑robots.txt文件:打开网站的robots.txt文件,将死链的URL地址添加到文件中。

一个网站的死链如何清除?有具体的步骤吗???

1、清除网站死链的具体步骤如下:找出死链:使用站长工具检测网站的链接,找出网站存在的死链。这一步是清除死链的前提,必须确保找出所有死链,以便后续处理。建立robots.txt屏蔽死链:将所有死链整理并建立一个文件夹。修改网站的robots.txt文件,添加对应的Disallow指令,禁止搜索引擎蜘蛛爬行这些死链所在的目录或页面。

2、找出死链使用站长工具检测网站的链接,找出网站存在的死链。

3、第一种:用360浏览器安装一个查找死链的插件,然后进入你的网站去查看,如果有死链,它的链接会显示为红色,下图看安装方法 第二种:手动查找,一般的小企业站的话手动查找也要不了多久,关键是手动查找能找得比较放心 。

4、文档编辑好后,将robots.txt上传到网站根目录即可实现对死链接的屏蔽。或者站长直接使用404错误页面,这个方法对于收录量大的站点还是很有用的,将站点内部存在的死链接直接跳转到404错误页面。然后通过404错误页面将用户引导到改版后的页面。这样可以降低网站推广流量的流失,使得用户可以找到站点。

5、要想解决网站被恶意劫持,可以给网站安装一个SSL证书,它的主要功能就是数据加密传输和服务器身份验证,其好处是:提升企业网站排名 目前Google、百度等主流搜索引擎表示会优先收录以HTTPS开头的网站,并赋予网站高权重,有效提高网站关键词的排名。网站安装SSL证书便可以实现网站从HTTP升级到HTTPS。

怎么删除死链删除死链后必应不收录网站

后台里面没有,应该是在别的栏目里面,你没有发现而已。如果真的没有的话,就在源码里面删除。有死链了就要果断的删除。

不建议删除栏目,可以在页面隐藏这个栏目如果实在要删,需要把删除的栏目里的所有页面地址到搜索引擎对应站长平台提交死链,如果不提交,搜索引擎再次爬取时发现大面积404页面,最后会对网站评级有影响 怎么把目录链接删了就再也查不到了?后台里面没有,应该是在别的栏目里面,你没有发现而已。

必应搜索引擎被k可能有多种原因,解决办法如下: 检查网站内容质量:确保网站内容原创、有价值且符合用户需求。避免大量抄袭、低质量或无意义的内容。 排查技术问题:检查网站是否存在加载缓慢、页面错误、死链等技术问题。修复这些问题有助于搜索引擎更好地抓取和索引网站。